メタバースと生きる人機共感社会へ ~CES2023をメディア環境研究所はどう見たか?

私たちは「世界で最も影響力のある技術展示会」と言われるCESを毎年訪問、取材してそこから見える未来のメディア環境を洞察し続けています。今年は3年ぶりにリアルでラスベガスを訪れ、現場を取材することが出来ました。

CES自体は、コロナ感染症拡大以降2021年はオンライン開催、2022年はリアル、オンライン同時開催ということでしたがオミクロン株の発生に伴い例年よりも小規模での開催に留まりました。2023年は本格的にその規模を回復。3200社以上が出展(昨年の2.6倍!)、11.5万人以上(昨年の1.4倍)が参加するなど活況を呈しました。ただ、4400社、17万人が参加した2020年と比較するとその規模は回復途上と言えるかもしれません。

今回、大きく掲げられたテーマは「ヒューマンセキュリティ」

今回のCES、主催者が設定した大きなテーマとして「ヒューマンセキュリティ」が掲げられていました。コロナ禍やウクライナ問題、SDGsの潮流の中でイノベーションを単なるビジネス拡大のためだけでなく、環境、食糧、貧困、衛生、人権などに課題を抱えるすべての人々のためのものとし、人類の安心、安全を実現していこう、というメッセージです。

その一例としてCESのオープニングキーノートで取り上げられたのは米国大手の農機具メーカー、ジョンディアの取り組み。米国人口のわずか2%である農業従事者が、人口増加する世界の食糧生産を支えることは大きな課題です。そこで開発された自動運転で走行するトラクターや、センサーを用いて従来の2倍のスピードで種付けする作付け機のイノベーションが語られました。

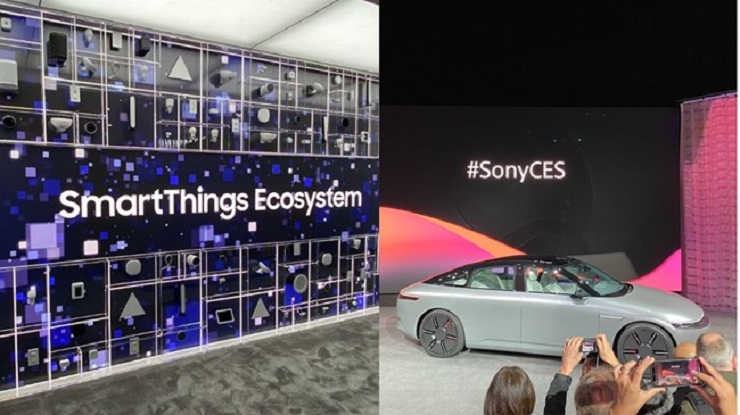

この他にも、スマートホーム関連機器を今まで以上に手間なく接続し、直感的に操作することのできるサムスンの新型スマートホームハブSmartThings Stationや、ソニーとホンダが開発した次世代電気自動車AFEELAなども話題になった今回のCES。

様々な話題がある中でメディア環境研究所がまず注目したのは、主催者がメディア向けの発表会で口にしたこの言葉でした。

「The Metaverse is Closer Than You Think (メタバースはあなたが思うよりも、もっと身近だ)」

メタバースが話題先行ともささやかれる中で、「ちょっと挑戦的かもしれないが」という前置きと共に語られたこの言葉。最初はピンとこなかった「思うよりも、もっと身近」ということの解像度が、取材するほどにどんどん上がっていったというところに今回のCESの醍醐味がありました。

バーチャルはフィジカルへ、フィジカルはバーチャルへ近づく

特に強く感じたのは、アバターやデジタルヒューマンなどの「バーチャル(仮想的)」な存在がフィジカル世界にどんどん進出し、身近になってきている。そして、フィジカル世界にいる我々自身は、容易にバーチャル世界へ移行できるようになっているという変化です。

進化するハプティクス

バーチャルがフィジカルへと進出するという点でわかりやすいのは、バーチャル世界の皮膚感覚を伝送するハプティクス技術の進化です。手袋をするだけ、簡単なスーツを羽織るだけでバーチャル世界の感覚をフィジカルで感じることが出来ます。また今回は匂いまで感じることのできるVRヘッドセットも話題になっていました。

VRヘッドセットなくバーチャル世界がフィジカル世界に現れる

ただこれだけではVRヘッドセットとその関連技術の進化にとどまっていますが、今回はそのような機器の枠を超えて、バーチャルな存在をフィジカル世界で表現するための技術が数多く出展されていました。

こちらは、カナダのARHT Media社が開発したCAPSULEというシステム。箱型の奥行きあるディスプレイにデジタルヒューマンが投影されています。ただし投影されているのは前面のディスプレイ部分だけですが、その奥には投影されている人物の影が映っていて、その前に立つと、まるでその箱の中に本当に人間がリアルに立っているかのように感じられます。店頭での接客、プレゼンテーションに使われたり、博物館で歴史上の人物や動物を展示するなどの活用が期待されているようです。

クルマのフロントガラスがバーチャル世界の入り口になる

また今回バーチャル世界が現れる場所として注目されたのがクルマのインパネやフロントガラスでした。BMWが発表した次世代コンセプトカー「i Vision Dee」はフロントガラスをAR/VRを表示する場所と位置づけ、フロントガラスにスピードなどの計器表示やカーナビの道案内を投影するだけでなく、モードの切り替えによって走行する車外の世界と連動したARやVR世界を投影。MIXED REALITY LVEL4という段階では、車外すべての風景がVR化するという未来をプレゼンテーションしました。

このようなビジョンは同じドイツの自動車メーカーメルセデス・ベンツでも語られており、クルマの前面(インパネ部分)に配置する一枚板のデジタルディスプレイを用いて、人工知能やゲームエンジンと共にドライバーのニーズに応じたデジタル世界を表現しようとしています。

裸眼でリアルな3D映像を楽しめる

また裸眼でバーチャル世界を楽しめる技術もますます進化。ソニーブースで展示されていたSPATIAL REALITY DISPLAYでは、ディスプレイの前の人の目の動きを計測し、最適な3D映像を表示。頭を動かすとその動きに合わせて映像を別の角度から見ることもできます。リアルな3D画像を、そこに実物があるかのように裸眼で感じることが可能なのです。このディスプレイはエンターテインメント、スポーツ、ゲームはもちろん研究や商品・デザイン開発時に遠隔で具体的なイメージを共有するための活用が想定されているようです。

このように見てみると、いわゆるバーチャルやメタバース世界は、VRヘッドセットやARグラスの中にとどまらず街中やクルマ、個人向けディスプレイ等々の形でフィジカル世界の様々な場所にあらわれ生活や仕事に溶け込んでいく未来が想像できるのではないでしょうか。

人は簡単にバーチャル世界へ行ける

さらにフィジカル世界にいる我々自身を容易にバーチャル世界へと移行させる技術も数多く展示されていました。

こちらはソニーのmocopiというモバイルモーションキャプチャー。頭、両手首、両足首、腰の6か所にモーションセンサーを装着し、スマホとペアリングするだけで、アバターの動きとフィジカルな人間の動きを同期させることができます。これを使えばVTuberのような活動はしやすくなりますし、VRChatなどのメタバースプラットフォームとも連携しているので、自分の動きを容易にメタバース世界へ移行させることもできるのです。

またアバターではなく、フィジカル世界にいる自分自身をメタバース世界へと簡単に移行させる技術も進んでいます。ソニーブースのMocopiの隣でプレゼンテーションされていたこの技術。7台ほどのカメラに囲まれた真ん中の人の動きが、右側のディスプレイのバーチャル空間の中にも再現されています。以前はもっと多くのカメラが必要なイメージの合った3D撮影ですが、いまやここまで簡易に人間をバーチャル世界の中へと移行、しかもリアルタイムに動画として移行させることができるのです。

自分のバーチャルヒューマン制作も簡単に

また、今ここにいる自分の動きをバーチャル世界へとリアルタイムに移行するだけでなく、簡単に自分のバーチャルヒューマンを作り、バーチャル世界で自在に動かすことのできる技術も生まれています。

これは韓国の人工知能企業Saltlux社が提供しているPLOONET STUDIOというサービス。スタジオでわずか50秒ほど身振り手ぶりを動画撮影するだけで、動き回る自分のバーチャルヒューマンが作成可能です。テキストを入力すれば英語、韓国語、日本語と様々な言語を喋らせることもでき、韓国や中国ではバーチャルヒューマンのアナウンサーがニュースを読み上げるなど実用化されています。

もはやアナウンサーが実際に話さなくても、特定のアナウンサーをリアルに再現したバーチャルヒューマンをプログラムして喋らせる、動かすことができるのです。

さて、取材からバーチャル世界がフィジカル世界に進出してくるだけでなく、フィジカル世界にいる我々自身がバーチャル世界と簡単につながることのできる変化が見えてきました。メタバース的仮想空間や仮想存在がより身近になってきている現実がお分かりになるのではないでしょうか。

では、このようにバーチャルとフィジカルが近づくメディア環境の中で、私たちの生活はどう変わるのでしょうか。

人とモノが共感しあう未来が見えてきた

ここで我々が注目したのが「人の気持ちを読み取る技術」「人に寄り添いコミュニケートできるモノ」の存在です。

まず「人の気持ちを読み取る技術」。以前より感情や気分をモニタリングする技術は存在していましたが、その技術がより進化しています。

こちらはカナダのヘルステック企業Nuralogix社が開発したAnuraというアプリ。カメラに30秒自分の顔を映すだけで心拍数や顔の皮膚年齢、心臓発作のリスクや糖尿病のリスクなどを測定してくれます。これだけでも驚きなのですが、さらに注目したいのは、身体のリスクだけでなくストレスレベルや不安、うつなど心の状態まで計測することができるということです。

このような技術はほかにもフランスのスタートアップが開発したEmobotというデバイスにも搭載されています。Emobotはカメラ付きのデバイスで微細な表情の変化から個人の精神状態を日々モニタリング。うつや不安などいつもとは異なる精神状態が確認された場合、アラートを発し早期のカウンセリングや医療につなげます。現在は高齢者施設などでの展開をメインにサービスを展開しているそうです。

こういった技術の発達を見てみるとついに機械が簡単に「人間の気分や感情、顔色をうかがう」ことができる時代が近づいてきたといえるでしょう。

人はモノと感情的に交流できる

その上でさらに注目したいのが「人に寄り添いコミュニケートできるモノ」の存在です。今回のCESでもこれまでのように多くのロボットが展示されていました。今までは、限定的な会話や可愛さ、癒しにとどまっていたこれらのロボット。多くの展示で顔を識別できるAIや会話AIを搭載し、従来以上に人間的、感情的なコミュニケーションまでできる様子が見られました。

昨年後半お絵描きAI、音楽創作AI、チャットAIなど様々なジェネレイティブAIの存在に一気に注目が集まりましたが、これらの寄り添い型ロボットがさらに高度な会話AIを搭載すれば人との会話も違和感のないものになっていきます。

(左よりDEEPBRAIN AI/CONVARSA from STORYFILE)

(左よりDEEPBRAIN AI/CONVARSA from STORYFILE)

先ほど簡単にデジタルヒューマンが作れることを紹介しましたが、実際にこれらのデジタルヒューマンの中には高度な会話AIを搭載し、質問すれば自由に答えを返答できるものも登場していました。写真右側のCONVERSAではバーチャルヒューマンに「どんな映画が好き?」と聞くとスタートレックの魅力について流ちょうに語ってくれました。コロナ禍以前の2020年のCESで展示されていたバーチャルヒューマンは非常に人間に近い見た目をアピールしており、自由に会話できるレベルでなかったことを考えると大きな進化を遂げたと言えるでしょう。

ここで気になるのが、このような高度な会話AIを搭載したロボットやバーチャルヒューマンに、前述した「人の気持ちを読み取る技術」が掛け合わされたらどうなるのか?ということです。ロボットやバーチャルヒューマンが人の顔色や気持ちをうかがい、その上で会話をする。人と「人ではないモノ」が感情的に交流する未来が見えてくるのではないでしょうか。

そして、このような未来を分かりやすく描いたのが、前述したBMWのコンセプトカー「i Vision Dee」のキーノートプレゼンテーションだったと言えるでしょう。

(movie from Consumer Technology Association)

(movie from Consumer Technology Association)

Deeはクルマでありながらフロント部分についたディスプレイをまるで顔のように表情豊かに変えながら、プレゼンターと軽妙に会話を交わします。プレゼンターはDeeを指して言います「彼女はデジタルの魂をもっている」と。

最後に

メディア環境研究所のCES2023レポートいかがだったでしょうか。最後にもう一度、冒頭紹介した言葉をまとめていきたいと思います。

「The Metaverse is Closer Than You Think (メタバースはあなたが思うよりも、もっと身近だ)」

「メタバース=デジタルでつくられた仮想的な(あたかもそこにいるかのような)存在や空間を受け入れ、活用する世界」と考えたとき、実はこれまでお話ししてきたメディア環境、未来像そのものが非常にメタバース的であると言えるのではないでしょうか。

バーチャル世界やメタバース内の存在は進化する様々なディスプレイを通してこれまでよりも容易にフィジカル世界に現れる。そしてフィジカル世界にいる私たちは、かつてよりも容易にバーチャル世界やメタバース内に自分自身の行動や姿を移行することが出来る。これから仮想空間・存在は実感としてますます身近に受け入れ、活用される存在になっていくでしょう。

そしてその環境の中で、気持ちに寄り添った会話もできるロボットやバーチャルヒューマン、モノという「仮想的な人格をもった存在」と交流し共感する未来がやってくるのです。その交流場所がフィジカル世界であれバーチャル世界であれ、人でないものをまるで人かのように受け入れ、活用し、時に共感しながら生きる社会はまさに、メタバース的といえるでしょう。

メタバースと生きる人機共感社会。そんな世界が、いま、我々が思っているより身近に近づいてきているのです。

執筆者プロフィール

※掲載している情報/見解、研究員や執筆者の所属/経歴/肩書などは掲載当時のものです。また、博報堂DYメディアパートナーズは、2025年4月より統合して博報堂になりましたが、サイト内の社名情報は掲載当時のものとなっています。